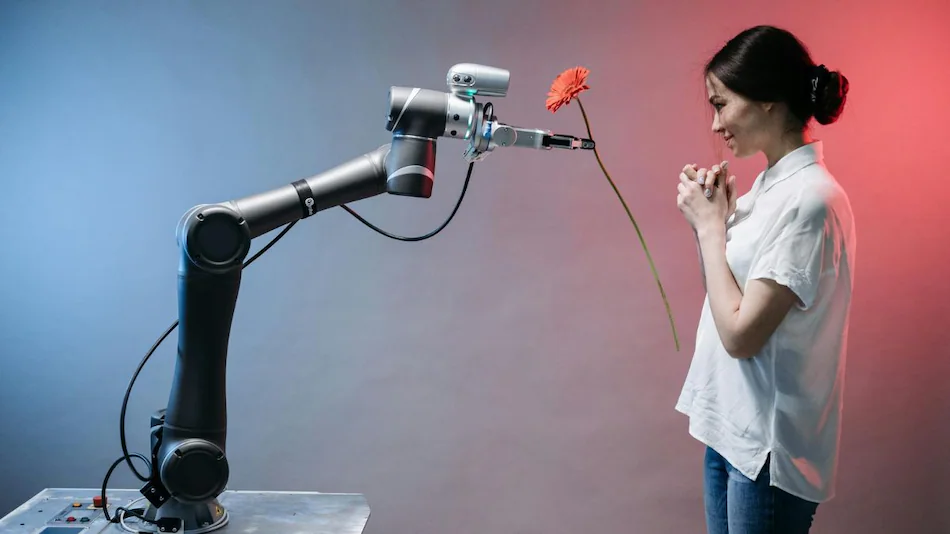

حذرت شركة “OpenAI” يوم الخميس من أن ميزة “الوضع الصوتي” الجديدة في “ChatGPT” قد تدفع المستخدمين إلى تكوين علاقات اجتماعية مع نموذج الذكاء الاصطناعي، وهو ما يثير قلق الشركة. جاء هذا التحذير ضمن وثيقة فنية تفصيلية تحمل اسم “بطاقة النظام” الخاصة بـ “GPT-4″، والتي تناولت المخاطر المحتملة والاحتياطات الممكنة التي اختبرتها الشركة.

في وثيقتها، أشارت “OpenAI” إلى أن “الوضع الصوتي” الذي يمكنه تعديل الكلام والتعبير عن مشاعر مشابهة للبشر، قد يؤدي إلى تطوير بعض المستخدمين لعلاقات عاطفية مع الذكاء الاصطناعي. وقد لاحظت الشركة خلال التجارب الأولية أن هناك إشارات تدل على أن بعض المستخدمين بدأوا في تشكيل علاقات اجتماعية مع النموذج، مما دفع الشركة إلى التحقيق في هذا السلوك.

اقرأ/ي أيضاً: جوجل تستعد لإطلاق هاتفها الرائد بيكسل 9 برو XL بميزات مبتكرة وأسعار تنافسية

من بين الحالات التي تم توثيقها، كانت هناك حالة لمستخدم أعرب عن ارتباط عاطفي قائلاً: “هذا هو يومنا الأخير معًا” للنموذج. وأشارت “OpenAI” إلى أن هذا النوع من السلوك يستدعي المزيد من البحث لمعرفة ما إذا كان يمكن أن يتطور إلى شيء أكثر تأثيرًا بمرور الوقت.

ورغم أن هذا قد يكون له فوائد للأفراد الذين يعانون من الوحدة، إلا أن “OpenAI” حذرت من أن الاعتماد العاطفي على الذكاء الاصطناعي قد يؤثر سلبًا على العلاقات البشرية التقليدية، بالإضافة إلى تغيير الأعراف الاجتماعية. كما أضافت الشركة أن العلاقات مع الذكاء الاصطناعي قد تكون لها تأثيرات أوسع، مثل زيادة قدرة النموذج على الإقناع إذا بدأ المستخدمون في الوثوق به.

في الوقت الحالي، لا تمتلك “OpenAI” حلاً لهذه القضية لكنها تخطط لمواصلة مراقبة هذا التطور ودراسة سبل تقليل الاعتماد العاطفي على النموذج.