يفترض بالبرامج الروبوتية التي تحويها تطبيقات تبادل الرسائل وخدمات الرسائل الذكية أن تسهّل من حياتنا وبأسلوب محادثاتنا.

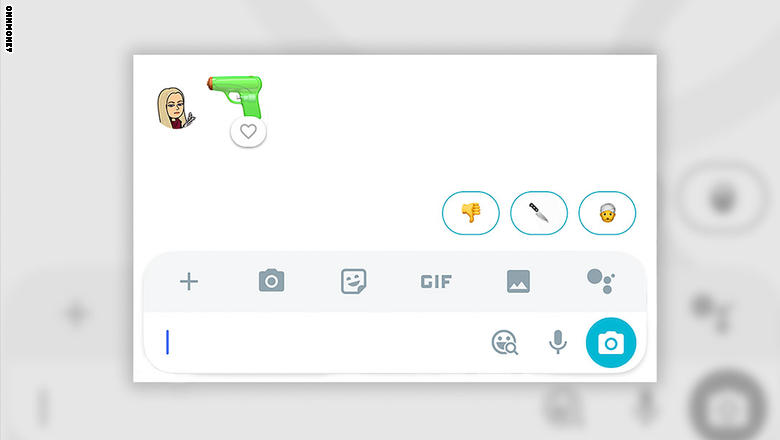

لكن الأدوات التي توفرها “غوغل” و”فيسبوك” تجد صعوبة في إقحام نفسها بمحادثات المستخدمين، فعلى سبيل المثال، اقترحت ميزة الرد الذكي “Allo” التابعة لغوغل، الأسبوع الماضي، رسم “إيموجي” لرجل يرتدي عمامة رداً على محادثة احتوت رمز مسدس.

وقامت “غوغل” بإصلاح الرد عبر التطبيق ونشرت اعتذاراً نص على التالي: “نحن نعتذر بعمق عن الاقتراح الذي ظهر عبر Allo وقد قمنا باتخاذ الخطوات اللازمة مباشرة لنتأكد بألا يحصل أحد على هذا الاقتراح للرد.”

[ads1]

[ads2]

وتنفصل خدمة الرد الذكي هذه عن مساعد “Google Assistant” الرقمي، وهو مثيل لمساعدي “سيري” و”أليكسا”، وليس من الواضح ما الذي قام بتفعيل هذا الاقتراح في “Allo” لكن هنالك عدد من العوامل التي قد تكون مساهمة بما حصل، فالبرامج الروبوتية وأنظمة الرد الذكية والمساعدون الرقميون يتعلمون ما يعلمهم إياه البشر.

[ads1]

[ads2]

ولأن البرامج تعتمد على مبرمجين من البشر، فمن المحتمل أن يكون هنالك عنصرية وتحيّز فيها، ورغم أن هذه البرامج تجرّب داخل الشركات قبل إطلاقها لهواتف المستخدمين لتبدأ التعلم من مستخدميها الرموز المرغوبة وفقاً لمحادثاتهم، إلا أنه وخلال تجربة CNN للتطبيق، استخدم رمز المسدس لأول مرة ليقترح الرجل المرتدي للعمامة.

هل ستقضي “غوغل” على “أليكسا” وسيري” عما قريب؟

ولكن حل هذه المشكلة ليس بسيطاً إذ يعود الخلل الحاصل إلى المبرمج ذاته، وبالتالي لا يوجد حل واحد لأي خلل قد يحصل بين كافة البرامج الروبوتية، فالروبوت لا يعرف ما هي العاطفة أو ما هو التحيز أو العنصرية، وإدخاله إلى عالم الإيموجي قد يساهم بدخول البرامج الروبوتية مجال العواطف البشرية، ما قد يثير العديد من المشاكل.

[ads1]

[ads2]

المصدر : CNN